graph LR

Bruker(["Bruker"]) <-.->|Forespørsel/<br/>Respons| LLM

LLM -.->|Kall | Tools[Tools]:::toolsNode

Tools -.->|Resultat | LLM

Agentisk AI - hva er det egentlig?

Innen AI-landskapet er det liten tvil om at “agentisk AI” og “AI-agenter” er årets mest hypede begreper, men det hersker stor uenighet om hva disse begrepene faktisk innebærer. Markedet preges av at enkelte kommersielle aktører tilsynelatende ukritisk har omdøpt eksisterende AI-løsninger til “agenter”, mens andre bruker agent-begrepet mer restriktivt. Dette minner meg litt om tidsperioden rundt 2016 da “AI” ble et markedsføringsbegrep for alt fra enkle lineære regresjonsmodeller til dype nevrale nettverk - uten at det fantes en bred enighet om den faktiske definisjonen.

I dette blogginnlegget foreslår jeg en praktisk kategorisering av AI-systemer, definerer hva AI-agenter er - etter min oppfatning - og illustrerer med konkrete eksempler. Merk at fokuset er på generelle AI-systemer basert på språkmodeller.

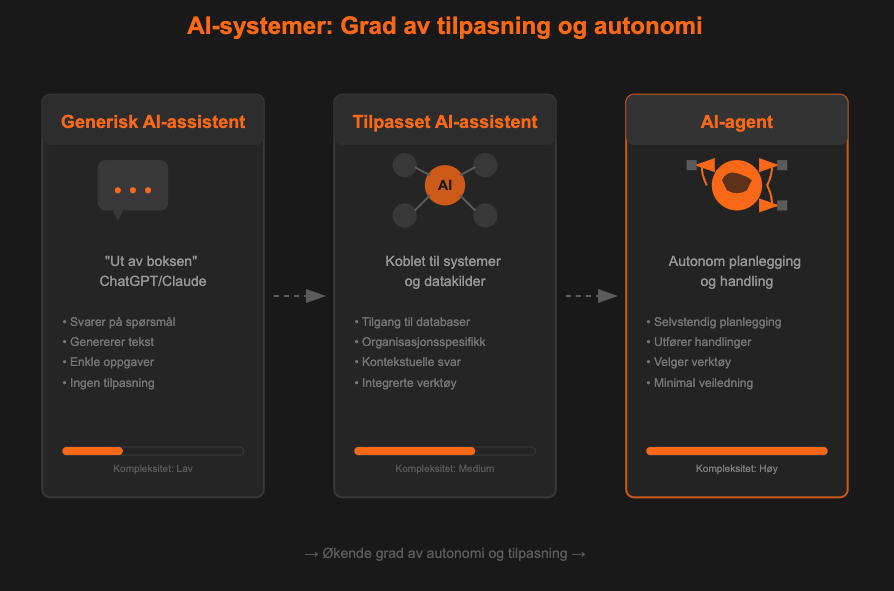

Inndeling av AI-systemer

LLM-baserte AI-systemer i organisasjoner kan grovt deles inn i tre kategorier – basert på grad av tilpasning og autonomi:

Generisk AI-assistent: Bruk av AI-modeller som f.eks. ChatGPT og Claude “ut av boksen”, med liten grad av tilpasning. Brukes til oppgaver som tekstgenerering, kodebistand og Q&A.

Tilpasset AI-assistent: Man utvider anvendelsesområdet til AI-assistenten med å gi den tilgang til nye systemer, datakilder og/eller verktøy. Resultatet er en AI-assistent som kan gi mer relevante og kontekstuelle svar basert på organisasjonens spesifikke informasjon og behov.

AI-agent: AI-agenter kjennetegnes ved deres evne til autonom planlegging og gjennomføring av handlinger. En slik agent kan motta en forespørsel fra en kunde og aktivt utføre nødvendige handlinger som å oppdatere abonnementsdetaljer, bestille produkter eller koordinere med andre systemer. Det som skiller agenten fra en tilpasset assistent er dens evne til selv å planlegge hvilke steg som må tas, velge riktige verktøy og utføre disse handlingene mer eller mindre autonomt.

Min opplevelse er at de fleste selskap har kommet et stykke med punkt 1 og delvis punkt 2, men veldig få har lykkes med punkt 3. Likevel er det nettopp her det største kommersielle potensialet ligger.

En lignende, alternativ inndeling av AI-systemer kan man finne i veilederen til bruk av KI-assistenter, publisert av Digitaliserings- og forvaltningsdepartementet1. Dette er en svært god oversikt med konkrete eksempler på bruk, men veilederen fokuserer i hovedsak på assistenter og ikke agenter.

Definisjon på AI-agent og eksempler

For å være presis kan vi definere AI-agenter som:

“AI-agenter er AI-baserte systemer som proaktivt forsøker å oppnå mål og fullføre oppgaver på vegne av brukeren. AI-agenter kan planlegge, resonnere, teste og utføre komplekse arbeidsflyter autonomt”

Inspirert av Google sin definisjon2, men tilpasset og oversatt

La oss se på noen konkrete eksempler for å skille mellom AI-assistenter og AI-agenter:

Du har laget en AI-chatbot hvor du har lastet opp noen dokumenter som den bruker som kunnskapsgrunnlag når den svarer på spørsmål. Er dette en agent? Jeg vil si nei - den planlegger ikke, kan ikke utføre handlinger eller tilpasse seg. Den handler åpenbart ikke autonomt på vegne av brukeren. Dette vil jeg kalle generisk bruk av språkmodeller.

Du har laget en AI-chatbot som er koblet opp mot datavarehuset ditt. Når du stiller spørsmål, utfører den SQL-spørringer og returnerer ønsket data. Er dette en AI-agent? Her befinner vi oss mer i grenseland, men jeg vil likevel kalle dette en tilpasset AI-assistent. Den har minimal autonomi, tilpasser seg ikke proaktivt, og har et svært begrenset handlingsrom. Den utfører handlinger, men kun på direkte forespørsel og innenfor strengt definerte rammer.

Du har laget et AI-system som sjekker og kontrollerer mottate fakturaer. AI-systemet kan bruke verktøy for å validere faktura opp mot prosjektdatabasen, gjøre vurderinger av beløpsstørrelser, kontrollere at alle felter er med, oppdatere regnskapssystemet og eskalere ved avvik. Dette er, etter min mening, et godt eksempel på en AI-agent. Systemet opererer autonomt, tar beslutninger basert på instrukser og egne vurderinger, og utfører handlinger på vegne av brukeren – uten at brukeren må initiere hver enkelt operasjon.

Her må det bemerkes at det finnes gråsoner, og mange systemer vil nok befinne seg i grenseland mellom en tilpasset assistent og en AI-agent.

Visualisering av arbeidsflyter

En ikke-agentisk arbeidsflyt vil typisk se noe slik ut:

Et sentralt kjennetegn med en agentisk AI-flyt er at den utfører et ikke-forhåndsbestemt antall oppgaver som påvirker miljøet, observerer utfall og selv avgjør når den er ferdig. 3 En agentisk arbeidsflyt kan se slik ut:

graph LR

Bruker(["Bruker"]):::bruker

LLM["LLM"]:::llm

Miljø(["Miljø"]):::env

Stopp["Stopp"]:::stopp

Bruker <-.->|Forespørsel/<br/>Respons| LLM

LLM -->|Handling| Miljø

Miljø -->|Tilbakemelding| LLM

LLM -.-> Stopp

classDef stopp fill:#ffccbc,stroke:#ff5722,stroke-width:2px

Det er vanlig at AI-agenter deles opp i sub-agents, som har mindre og mer konkrete oppgaver. AI presterer generelt bedre med konkrete oppgaver og uten irrelevant kontekst, så en “orkestrator-agent” kan tildele oppgaver til mer spissede sub-agenter, som igjen har tilgang på egne verktøy. Et AI-system som benytter sub-agents kan se noe slik ut:

graph LR

Bruker(["Bruker"]):::bruker

LLM["Koordinator LLM"]:::llm

Miljø(["Miljø"]):::env

Stopp["Stopp"]:::stopp

%% Sub-agents

Agent1["Sub-Agent 1<br/>Analyse"]:::agent

Agent2["Sub-Agent 2<br/>Planlegging"]:::agent

Agent3["Sub-Agent 3<br/>Utførelse"]:::agent

%% Tools/Actions for each agent

Tool1["Verktøy/<br/>Databaser"]:::tool

Tool2["Ressurs-<br/>allokering"]:::tool

Tool3["API/<br/>Integrasjoner"]:::tool

%% Main flow

Bruker <-.->|Forespørsel/<br/>Respons| LLM

LLM -.-> Stopp

%% LLM to Sub-agents

LLM -->|Delegerer| Agent1

LLM -->|Delegerer| Agent2

LLM -->|Delegerer| Agent3

%% Sub-agents feedback to LLM

Agent1 -->|Resultater| LLM

Agent2 -->|Resultater| LLM

Agent3 -->|Resultater| LLM

%% Sub-agents to Tools

Agent1 <-->|Spørring| Tool1

Agent2 <-->|Koordinering| Tool2

Agent3 <-->|Kommandoer| Tool3

%% Actions to Environment

Tool1 -->|Handling| Miljø

Tool2 -->|Handling| Miljø

Tool3 -->|Handling| Miljø

%% Environment feedback

Miljø -->|Tilbakemelding| LLM

classDef stopp fill:#ffccbc,stroke:#ff5722,stroke-width:2px

Merk at “brukeren” i et slikt system ikke nødvendigvis er i form av en chat-forespørsel, agenten kan også trigges automatisk av f.eks. et saksbehandlingssystem eller en mottatt e-post.

Bruk av AI-agenter i praksis

Den klart vanligste og mest verdiskapende use-casen for AI-agenter per i dag er nok innen koding. Claude Code, OpenAI Codex og Gemini CLI er eksempler på AI-agenter som er spesielt utviklet for å bistå med koding og programmering. Disse agentene mottar generelle eller spesifikke instruksjoner og kan deretter autonomt opprette filer, skrive, teste og redigere kode. Disse agentene har allerede blitt enormt populære, og de har allerede endret måten mange team utvikler programvare på.

Utover koding finnes det en rekke ferdiglagde AI-agenter for ulike formål. ChatGPT Agent kan for eksempel kontrollere en nettleser og fullføre ulike typer oppgaver (med varierende grad av suksess). Manus er en annen generell AI-agent som kan utføre et bredt spekter av oppgaver. Her kommer det stadig flere aktører på markedet, enten med spisse løsninger for spesifikke områder eller mer generelle løsninger.

For mer spesifikke eller komplekse bruksområder kan det lønne seg å bygge egne AI-agenter. Dette gir full kontroll over funksjonalitet, integrasjoner og sikkerhet. Utviklingen av skreddersydde agenter gjøres ofte med open source-verktøy, f.eks. LangGraph i Python, kombinert med egne eller ferdiglagde MCP-servere. Alternativt kan man benytte kommersielle verktøy og plattformer. Azure AI Foundry Agent Service, Copilot Studio, Vertex AI Agent Builder og Amazon Bedrock Agents er bare noen eksempler på slike kommersielle løsninger som tilbyr slike plattformer for utvikling og produksjonssetting av AI-agenter, typisk med muligheter for grafiske brukergrensesnitt og forhåndsbygde integrasjoner.

Er teknologien klar?

Min mening er at teknologien per i dag bare delvis er klar for autonome AI-agenter. Det finnes isolerte bruksområder der agentene fungerer godt - forutsatt strenge kontrollmekanismer. Men for de fleste komplekse oppgaver vil det være behov for bedre og mer presise språkmodeller før AI-agentene kan slippes løs i produksjon.

Selv om svært mange snakker om AI-agenter og har bygget ulike Proof of Concepts, er det etter min erfaring få selskap i Norge som i dag bruker teknologien til å automatisere kritiske prosesser i stor skala.

Det store problemet er fortsatt hallusinering. AI-agenter feiler fortsatt for ofte på overraskende og uforutsigbare måter. Jeg har f.eks. opplevd at ChatGPT Agent brukte over 30 minutter på å forsøke å bestille en pizza for meg - før den svarte at det ikke var noen åpne pizza-restauranter i nærheten (i realiteten var nærmeste åpne pizza-restaurant under 100 meter unna). Det finnes også tallrike eksempler på kodeagenter som har handlet destruktivt, som når de har slettet databaser eller opplevd systemkollaps som kan ligne på mentale sammenbrudd.

OpenAI skrev nylig en forskningsartikkel på hvorfor språkmodeller hallusinerer. 4 En av årsakene de trekker frem er at AI-modellene blir evaluert på et sett med tester. Hvis man tar en eksamen, har man typisk høyere sannsynlighet for å få rett svar ved å tippe enn ved å svare blankt. Dette har AI-modellene også plukket opp, og har dermed lært seg at gjetting er gunstig. Å lære AI å innrømme når den er usikker, vil være sentralt i videre utvikling. GPT-5 (i “thinking”-modus) var for eksempel et steg i riktig retning, men det er fortsatt et godt stykke igjen. En nylig artikkel fra Nvidia konkluderte med at mindre og mer spissede språkmodeller kan være fremtiden for agentisk AI, istedenfor å bruke én enorm “generalist” modell som vi gjør i dag.5

Det finnes derimot mange gode bruksområder hvor AI-agenter kan være verdiskapende - så lenge man har en “human in the loop”. For eksempel kan en AI-agent autonomt hente inn beslutningsgrunnlag til en saksbehandler, men et menneske vurderer informasjonen og gjør den endelige beslutningen. Dette vil redusere risikoen betydelig, samtidig som effektivitetsgevinstene fortsatt er høy. Tilsvarende brukes de fleste kode-agenter på samme måte, hvor programmerere jobber tett sammen med AI-agenten, vurderer koden, tester og itererer.

Selv om teknologien fortsatt er noe umoden, vil jeg anbefale å begynne å eksperimentere med agentisk AI og kartlegge potensielle bruksområder på kort (typisk med “human-in-the-loop”) og lengre sikt (mer autonome). Dermed kan man begynne å få gevinst av de lavthengende fruktene, mens når dagen kommer hvor språkmodellene har blitt mer pålitelige og intelligente, vil man raskere være i stand til å hente ut vesentlige effektiviseringsgevinster.